Tehisintellekt ja tehnoloogia areng

Riistvara roll tehisintellektis ja ujukoma tehted sekundis

Tehisintellekti arengus mängib rolli mitu faktorit, kuid vaieldamatult kõige suuremat rolli mängib riistvara. Nimelt, tehisintellekt areneb riistvara arengu järgi. Riistvara areng ei ole nii stabiilne kui paljud arvaksid, eriti eeldades, et kõik jälgib Moore’s seadust.

Stagnatsioon on üks faktor mis mõjutab riistvara arengut. Hea näide sellest, oleks see, kui Intel stagneerus 2012-2019 keskprotsessorite alal, kuna neil ei olnud mingit konkurentsi. Peaks mainima, et keskprotsessorid ei mängi enam nii suurt rolli komputatsioonis, seda rolli täidab rohkem nüüd accelerator-id (näiteks: ASIC, FPGA ja GPU) millel mõne tuuma asemel, on neid tuhandeid - GPU-des on nende nimi ALU (Arithmetic Logic Unit), mille kogus on viimasel ajal väga suureks läinud. ALU on fundamentaalne täieliku komputatsiooni jõudluse arvutamiseks ja selle niinimetatud universaalne mõõtühik on FLOPS (Floating Point Operations Per Second), täpsemalt FP32 FLOP, kuid tänapäeval kasutatakse TFLOP-i: T indikeerib tera, ehk 10 astmel 12.

FLOPS = ALU-de kogus * taktsagedus (Hz) * 2

Kas FLOPS on ainus mõõtühik?

Lühike vastus on ei. FP32 FLOP võtab arvesse ainult ujukomaarvude arvutamist. Seal on olemas ka INT, ehk täisarv. Number 32, FP32-s tähendab 32-bitti täpsust. On olemas 8, 16, 64 ja muid täpsusi. Siiski, on FP32 FLOP tuntud kõige paremini ning kasutatakse kõige rohkem. TFLOPS on kasulikeim mõõtühik GPU-de jaoks - mis on siiani laialdaselt kasutatud superarvutites & tavaarvutites. Tulevikus hakkame nägema rohkem spetsiifilisi kiipe & tükke neist sisse ehitatud protsessoritesse - või videokaartidesse: Tensor core - Nvidia, TPU - ARM-baasil SoC-d. Tegemist on ASIC/FPGA-dega - mis on väga head spetsiifilistes asjades, näiteks tehisintellekti kiirendamises.

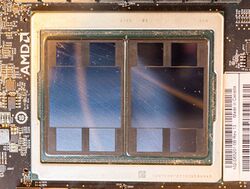

Praegused kõige kiiremad GPU-d

GPU-d, kuna neid kasutatakse üldiselt kõige rohkem suure jõudluse saamiseks superarvutites - samuti on GPU tavaliselt kõige võimelisem arvutis. On öeldud, et inimese aju on umbkaudselt 100-10000 TFLOPS (eeldatavasti võimatu saada sellist numbrit täpselt), praegune kõige kiirem GPU (Graphics Processing Unit), AMD MI250X-l on umbes 96 TFLOPS FP32 komputatsiooni võimsust. Võrreldes eelmise parimaga, Nvidia A100 & AMD MI100, on MI250X circa 2-5x kiirem toores FP32 komputatsioonis. Palju sellest on tänu uuele MCM (Multi-chip module) arhitektuurile & TSMC 6nm tootmisprotsessile [1].

Millest tuleneb kiirus GPU-s, ehk mikrokiibis?

Kõik mikrokiibid, põhiliselt räni baasil, kasutavad transistoreid arvutusteks. Transistor ise on kolme väljaviiguga pooljuhtseadis ehk triood. Üldiselt on transistorid, mis on räni baasil, MOSFET (Metal-oxide-semiconductor-field-effect transistor) sarnased. Tänapäeval on keskmisel kiibil üle 1000 miljoni transistori [2].

Transistoreid disainitakse erinevaks, eriti nüüd, sest tootmisprotsess on nii väikseks läinud millega on tulnud kaasa mõningaid probleeme - suurim neist olles elektronide lekkimine üle transistorite ja kui palju ruumi transistor ise võtab. Praegusel hetkel kasutatuim transistori disain modernsetes mikrokiipides on FinFET.

Väiksem transistori suurus on väga oluline järgmiste punktide pärast: On võimalik rohkem transistore ühele kiibile mahutada - mis tähendab ka seda, et rohkem tuumasi, ALU-si, mälu saab panna kiibile. Energiakulu on tunduvalt väiksem, et saada võrdväärset jõudlust eelmise generatsiooni mikrokiibiga. Samuti takistus on väiksem üle sama arv transistore. Sama võimsa kiibi tootmine (võrreldes eelmise generatsiooniga) on odavam kuna saab teha väiksema kiibi. Räniplaadid on üpris kallid & mida suurem on kiip, seda rohkem defekte tekib seal - seega loogiliselt, kui kiip on väiksem, saab ühelt plaadilt rohkem kiipe mis omaette tähendab ka seda, et see on odavam.

Üldisemalt, on olemas laialiselt tuntud seadus nimega Moore’s Law. Moore’s Law eeldab, et iga 2 aasta tagant kahekordistub transistorite arv mikrokiipides. Tegemist, aga, ei ole teaduslikult tõestatud teooriaga - ega seadusega. Siiski, on Moore’ seadus üldises pildis täpne olnud. Moore’ seadus on surmaohus olnud tükk aega tootmisprotsessi pärast. Nimelt, tootmisprotsess on jõudmas sinna punkti kus ei ole füüsiliselt võimalik väiksemaks minna. Praegune masstoodangus kõige väiksem protsess on 5nm - varsti 4nm.

IBM on demonstreerinud 2nm transistorit - seega sellest väiksem on eeldatavasti võimalik. Teoorias rääkides, võib olla 1 aatomi suurune transistor võimalik, aga sellest väiksemat ei ole võimalik teha. Kuidas hoida Moore’ seadust elus? - erinevad tehnoloogiad mida implementeeritakse mikrokiipidesse saavad hoida sellist arbitraarset seadust kauemaks elus: MCM, 3D-packaging.

Jõudlus tulevikus

Ennustada midagi sellist, on väga raske kuna me ei tea ette, mis tulevikus võib juhtuda. Olgu järjekordne stagnatsioon - või hoopis revolutsiooniline areng. Praegusel hetkel, on kõige kiirem GPU 96 TFLOPS-i (MI250X). Ei ole ebarealistlik öelda, et 2027 paiku on võimalik tavainimesel soetada sellise võimsusega videokaarti 1000€ eest.

Tänapäeval valmivad exascale superarvutid - mis suudavad teha 10 astmel 18 kalkulatsiooni sekundis. Arvestades mitte-ametlikku informatsiooni tuleviku kiipide kohta, ei oleks konservatiivne öelda, et 2027-2030 sekkub juurde ka zettascale superarvutid.

Tuleviku ennustused

Paljud ennustused tuleviku komputatsiooni jõudlusest on valed olnud. Suurem osa ajast on leida, et ennustused on liialt konservatiivsed & üleüldiselt alahindavad arengut. On ka ennustusi, mis võtavad teada, et paljud prognoosid on valed olnud kuna need olid alahinnatud - sel juhul on tihti ülehinnatud.

Kõige täpsem ennustus, mis on laialt levinud, on Tim Urbani poolt, tema artiklis “The AI Revolution: The Road to Superintelligence”. Tegemist on artikliga, mis kirjutati aastal 2015, kuid estimatsioon on liialt optimistlik. Ta ennustas, et aastaks 2025 on võimalik kiip, mis maksab 1000$ & on 10 astmel 16 CPS (Calculations per second, umbes võrdväärne FLOP-ile). Kahjuks, praegu ei tundu, et seda juhtub, sest praegune kõige võimsam kiip, mis maksab 1000$, võimaldab ainult 30 TFLOPS. Aastal 2025, 1000$ eest on eeldatavasti võimalik saada kiip, mis võimaldab 100 TFLOPS-i.

Võib tõesti kasutada Moore’ seadust - detailselt, aga, on praktiliselt võimatu ennustada komputatsiooni võimsust tulevikus. Kui oleks võimalik küsida kiibi arhitektidelt, aastal 2000, mis on kiipide komputaalne võimsus 2020, nad paneksid rohkelt mööda. Arengul on liiga palju muutujaid, et seda ennustada laias pildis kümneid aastaid ette.

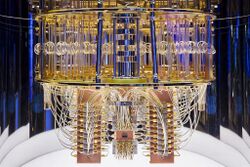

Kvantarvutid

Kvantarvuti kasutab ära kvantmehaanikat, et saada hiiglaslike tõuse komputatsioon jõudluses. Praegusel hetkel ei usuta, et kvantarvutid asendavad arvuteid, et lahendada lihtsamaid probleeme - mis iseenesest on mõistlik, sest kvantarvuti nii-öelda kiibid töötavad ainult ekstreemselt külmades temperatuurides kuid mõte ei ole asendada tavainimese arvuit, vaid rõhk on tehisintellektil, on võimalik kvantarvutit kasutada ka tehisintellekti kiirendamiseks.

Kvantarvuti on eriline, sest see kasutab qubitte, ehk kvantbitte. Kvantbitt saab olla 1 ja 0 samal ajal, erinevalt tavalisest bitist, mis on kas 0 või 1. Kvantbitil on veel omadusi, näiteks superposition, mis võimaldab mitmel kvantbitil arvutada välja mitu tulemust samaaegselt. Selle abil on võimalik lahendada probleeme, mis võivad tunduda väga keerulised tavalisele arvutile - näiteks kombinatoorika [3].

Kui kasulik on kvantarvuti? Palju rõhku on pandud simulatsioonidele - olgu see meditsiin või tehisintellekt. On tehtud uuringuid, mis tõestavad, et kvantarvutid suudavad tunduvalt kiiremalt joosta tehisintellekti jaoks algoritme. Täpseid arve ei ole antud, kui palju kiirem kvantarvuti tehisintellektis on, kuid on tõestatud selle potentsiaali - seega tulevik on hele [3].

AI liigid

ANI ehk Kitsas Tehisintellekt. ANI on kasutuses tänapäeval rohkelt, näiteks: enamus autod, telefonid ja muu riistvara - seda kõik võimaldab tarkvara, ehk ANI. ANI on tehisintellekt, mis on mõeldud lahendama ühte ülesannet: see tehisintellekt suudab mängida malet kõrgemal tasemel kui kõige parim male mängija tänapäeval. Üks tehisintellekti firmadest, nimega OpenAI, kirjutas tehisintellekti programmi, mis mängib Dota 2 professionaalsete mängijate vastu efektiivselt, ning suutis võita 99.4% mängudest. Tesla kasutab ANI-d, et osaliselt võimaldada enda sõidukitel juhtida iseennast ja ennetada arvariisid, reageerides kiiresti sõites autoga ohutusse [4].

AGI ehk Üldine Tehisintellekt. AGI on teiste sõnadega tugev tehisintellekt või inimmõistsega samal tasemel tehisintellekt. See tehisintellekt suudab teha kõike mida suudab inimene teha. Ta suudab probleeme lahendada, plaanida, abstraktselt mõelda, õppida kiirelt ja enda kogemustest. AGI-d pole veel saavutatud tänapäeval, vaatamata sellest, enamus firmad reklaamivad, et neil on AGI tasemel tehisintellekt, aga tegelikkus on see, et neil on ainult ANI tasemel tehisintellekt, mis juhtumisi on optimiseeritud ainult ühe probleemi lahendamiseks [4].

ASI ehk Tehis Superintellekt. ASI võib olla natukene targem kui inimene, aga võib olla ka üle miljardi korra targem. Mis on huvitav on see, et loomade ja inimeste intelligentsuse vahe on ekstreemselt suur võrreldes lolli ja targa inimese vahelise intelligentsusega. Ehk hetkel millal meie tehisintellekt jõuab ‘lolli inimese’ tasemele, järgmine hetk millal märkame, on AI meist juba ammu ette jõudnud. Sellise tehisintellekti saavutamiseni on veel mõnda aega minna, aga kui jõutakse sellisele tasemele, muutub inimeste elu eeldatavasti drastiliselt paremaks, kuid kuna tegemist on väga targa tehisintellektiga, on võimalik ka täielik polaarne vastand [4]. Kuidas aga on meil võimalik jõuda AGI-ni?

AI mudelid

Teadlased on otsustanud võtta inspiratsiooni loodusest ehk täpsemalt inimeste ajudest, sest inimeste ajud on bioloogiline tõestus, et tarka aju on võimalik teha. Kui teadlased seda lõpuks pöördprojekteerida suudavad siis saavad nad leida sellest inspiratsiooni ning innoveerida uusi ideid kuidas teha tehisintellekti efektiivsemaks ning vähem energia kulukamaks.

Nii bioloogilised kui ka tehnoloogilised intellektid kasutavad tihti neurovõrke, millest viimane väga tihti võtabki inspiratsiooni bioloogilisest intelligentsusest. Neurovõrkudes on neuronid ühendatud omavahel läbi sünapside, ning kui mingi tegevus on positiivne ja käivitab tasumehannismi (näiteks dopamiini), siis see neuronite vaheline tee ehk ajuühendus muutub tugevamaks. Eksisteerib ka vastupidine efekt: kui mingi tegevus on halb, siis antud ajuühendus tulevikus nõrgeneb. Seda meetodit kasutakse ka tehisintellektiteaduses läbi võtte nimega stiimulõpe. Kui antakse programmile mingi objekt ja programm arvab selle õigesti ära, siis tugevneb ajuühendus - kui on vale ja saab teada mis tegelikkus oli, proovib programm unustada seost millega ta jõudis vale vastuseni. Võõraste objektide juhul, saab lisada juurde andmebaasi, tekitades uue ühenduse [5].

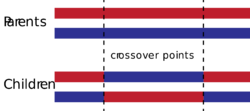

Geneetilised algoritmid

Evolutsiooni saab emuleerida kasutades geneetika algoritmi. Geneetika algoritm genereerib suvalise populatsiooni programme nagu looduses analoogiliselt leitavale evolutsioonile, pärast mida ta kasutab sihifunktsiooni, et määrata iga funktsiooni efektiivsuse ja seejärel valib parimad programmid, mis ta omavahel geneetiliselt rekombineerib (crossover) uued programmid koos mõne mutatsiooniga ning mutatsioon sarnaneb ise local search algoritmile.

Geneetika algoritmiga saab genereerida evolutsiooniliselt uusi ajusid, mille seast valitakse kõige targem aju, isegi kui sellel ajul on negatiivsed omaduses nagu energiakulu suurus on liiga suur siis valitakse ta ikka, sest töö eesmärk on leida kõige targem aju millest genereerida uusi targemaid ajusid kuni lõpuks jõutakse välja AGI tasemel ajuni [6].

AGI raskuste ületamine

Kui AGI arendus osutub liiga raskeks, siis üks võimalus mida teadlased kasutavad on probleemi delegeerimine ANI-le. Üleaja on arvutitel võimalik jõuda õige lahenduseni AGI probleemile iseenesest, mis vabastab meid probleemist, milleks on raskete matemaatiliste algoritmide ja probleemide lahendamine. Meetod mõnes mõttes sarnaneb hüperheuristikatele, mis üritavad läbi ML meetodite valida ja kombineerida lihtsamaid heuristikaid, või sel juhul, konstrueerida tehisintellekte.

Tehnoloogilised prognoosid

Tänapäeva kultuuris võib igal pool leida ebamäärast kartust tehisintellekti suhtes: tegu on tehnoloogiaga mille olemuses ei olda kindlad ja millel on tõsised implikatsioonid tervele inimkonnale. Ka spetsialistide ringides leidub igasuguseid analüüse AI suhtes, alates nendest kes usuvad et see ei tule kunagi, nendeni kes arvavad et singulaarsus on kohe meie nurga taga ja tõotab ainult halba.

Mõnevad usuvad, et AI prognoosid on liiga optimistlikud. Tihti näidatakse, et kõik eelmised ennustused inimeste poolt, keda loetaks valdkonnas ekspertideks, on täielikult mööda läinud. Üks uuring kompileeris üle 250 tähtsa ennustuse ja leidis, et nende kvaliteet on keskmiselt väga madal. Ei leitud isegi suurt vahet ekspertide ja mitteprofessionalide vahel. Lisaks ka jõuti üleüldise teoreetilise arvamuseni, et AI ennustuste baas ei saa olla teoreetiliselt eriti tugev [7].

AI riskid

Väga tüüpiliseks mureks on apokalüptilised stsenaariod nagu “kuri tehisintellekt” või instrumental convergence. Esimene nendest muredest tihti tuleneb aga tehisintellekti antropomorfeerimisest, ehk ekslik inimlike omaduste sidumine AI-le. Arvatavasti aga keskkond, milles me arendame tehisintellekti, ei arene samat moodi nagu inimkond. Tehisintellektide puhul oleme meie need, kes annavad AI-le normatiivse jõu, ehk teises mõttes väärtused või näiteks geneetilise programmeerimise puhul sihifunktsioonid. Tehisintellektil ei tekigi situatsiooni, mis nõuaks tal arendada tundeid nagu ahnus või pettlikus (Yudkowsky 2008). Realistlikumaks probleemiks on aga teine mainitud mure, mille alusel intelligentsed agendid nähtavisti ohutute eesmärkidega võivad väljendada ennast üllatavalt ja mitteinimlikult. Kõige populaarsem näide sellest on kirjaklambri maksimeerija. Mõtteeksperiment palub ette kujutada grupi teadlas-ettevõtjaid, kes soovivad toota võimalikult palju kirjaklambreid, ja selle eesmärgi täitmiseks koostasid nad tehisintellekti. Mida nad aga ei oodanud on see, et AI saab aru, et inimesed raiskavad tähtsaid ressursse, millest oleks muidu võimalik teha isegi rohkem kirjaklambreid. Orjastatud inimkond on ka arvatavasti produktiivsem kirjaklambrite tootja. Selle probleemi üldistatud vorm on valesti sätitud AI sihid, mida leiab ka olemasolevate ANI sihifunktsioonide puhul [8].

Mõned tugevamad AI-d peaksid suutma ka jõuda mudeliteni, mis üritavad sihifunktsiooni “petta” suurema kasumini jõudmiseks, sest meie tegelikke soove saame me arvutile kommunikeerida ainult sihifunktsioonväärtuste kaudu. Seesugune AI-tegevus on juba esinenud näiteks roobotikas või videomänguarenduses. Viimase näiteks oleks Tetrise mängubot, kelle sihifunktsioon arvutas tema ellujäämisaega. AI aga suutis koodivea üles leides ellu jäämiseks mängu enda pausile panna [8].

Küll aga ei ole tehisintellektil motivatsiooni muuta oma põhilisi väärtusi, sest see oleks vastuolus tema olemasolevatele motivatsioonidele, milleks on antud väärtuste maksimeerimine. Sarnane küsimus tekib ka ühes posthumanismi liigis, kus küsitakse, et kas inimesest võib kunagi areneda olend, kellel on täielikult erinevad põhiväärtused meie omadest. Pole aga selget põhjust, miks me peaksime soovima oma soove muuta, kui need uued soovid just ei aita kaasa mõnedele muudele praegustele soovidele.

Kui tõenäoline on, et sellised probleemid meil tekivad? Selliseid riske tõstab fakt, et inimkond ei tööta AGI-de kallal koos ühe tiimina (ega praeguse ajalootrajektoori järgide ennustades arvatavasti ei hakkagi). Selle asemel konkureerivad omavahel riigid ja ka riikides asetsevad korporatsioonid, mis kõik soovivad kiirendada tehnoloogiaarengut kasumi ja võimu maksimeerimiseks; ohutus jääb sekundaarseks. Eriti tugev näide oleks võistlus singulaarsuseni, sest esimene kes selleni jõuab, arvatavasti jääb teistest ette juba ajaloo lõpuni [9].

Neo-ludistlik mõtlemine pole aga lahendus kõikidele nendele muredele. AI arendust ei ole võimalik praeguseid jõudünaamikaid arvestades peatada, eelistatam on hoopis vastutustundlik arendus. Tehnoloogial on radikaalne potentsiaal muuta maailma: muutused mida võib tuua tehnoloogiline singulaarsus ei ole isegi mudelleeritavad. Ennustada ette, mis juhtub hetkel mil AI suudab ennast edasi arendada ja tungida ka läbi riistvaraprobleemide, on hetk mil inimkond asub täielikusse tundmatusse. Üks tähtis idee on selline, mis väidab, et AI muutub hoopis meie enda osaks: sel juhul ei olegi olemas täielikult eraldi AI agenti oma normatiivsete eesmärkidega, vaid hoopis metafooriline neljas ajukiht. Isegi praegu võib interpreeterida koduarvuteid ja telefone kui välimisi osi meie ajust. Internet ja otsingumootorid on justkui kõrge latsentsusega massiivne mälukogum.

- ↑ AI Impacts. 2017. “Brain performance in FLOPS – AI Impacts.” AI Impacts. https://aiimpacts.org/brain-performance-in-flops/.

- ↑ Elprocus. n.d. “What is the MOSFET: Basics, Working Principle and Applications.” ElProCus. https://www.elprocus.com/mosfet-as-a-switch-circuit-diagram-free-circuits/.

- ↑ 3.0 3.1 Giles, Martin. 2019. “Explainer: What is a quantum computer?” MIT Technology Review. https://www.technologyreview.com/2019/01/29/66141/what-is-quantum-computing/.

- ↑ 4.0 4.1 4.2 Strelkova, Olga. n.d. “Three Types of Artificial Intelligence.” Khmelnitsky National University. https://conf.ztu.edu.ua/wp-content/uploads/2017/05/142.pdf.

- ↑ Goertzel, Ben. 2016. “Artificial General Intelligence.” Scholarpedia. http://www.scholarpedia.org/article/Artificial_General_Intelligence.

- ↑ “Crossover (genetic algorithm).” n.d. Wikipedia. https://en.wikipedia.org/wiki/Crossover_(genetic_algorithm).

- ↑ Sotala, Kaj, and Stuart Armstrong. 2014. “Beyond Artificial Intelligence.” In Beyond Artificial Intelligence: The Disappearing Human-Machine Divide, edited by Eva Zackova, Jozef Kelemen, and Jan Romportl, 11-29. N.p.: Springer International Publishing. 10.1007/978-3-319-09668-1_2.

- ↑ 8.0 8.1 “Misaligned goals in artificial intelligence.” n.d. Wikipedia. https://en.wikipedia.org/wiki/Misaligned_goals_in_artificial_intelligence.

- ↑ Yudkowsky, Eliezer. 2008. “Artificial Intelligence as a positive and negative factor in global risk.” In Global Catastrophic Risks, edited by Milan M. Cirkovic and Nick Bostrom. N.p.: OUP Oxford.